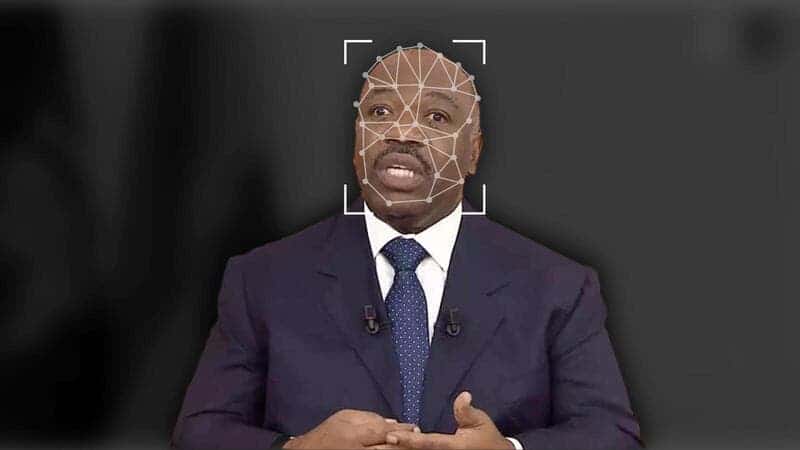

Gabon, Africa, 1 gennaio 2019. Il Governo in carica rilascia un video in cui il Presidente Ali Bongo, come di consueto, fa i suoi auguri per il nuovo anno a tutta la popolazione. Fin qui nulla di strano, se non fosse che il Presidente Bongo era letteralmente scomparso dalla scena pubblica da mesi per via di alcune cure mediche a cui era stato costretto a sottoporsi in Arabia Saudita.

Nel periodo in cui Ali Bongo si era assentato lo Stato aveva sofferto di una profonda instabilità politica, generata anche da voci che davano il Presidente come in fin di vita, se non addirittura già morto. Proprio a causa della tensione diffusa, da un lato, una parte della popolazione aveva visto il video-discorso come una boccata d’aria fresca mentre, dall’altro, molti credevano che nel video ci fosse più di un qualcosa che non andava: lo schema inconsueto del discorso, la fisionomia, i cali di pixel, il fatto che il presidente sembrava sbattere le palpebre molto meno rispetto rispetto ai normali esseri umani, tutti elementi che avevano fatto insorgere diversi dubbi nella popolazione. Così, molti membri dell’opposizione arrivarono a sostenere addirittura che quello nel video in realtà non era il vero Capo di Stato gabonese e che, di conseguenza l’intero video fosse in realtà il prodotto di un’intelligenza artificiale.

Un “DeepFake” insomma.

Cosa significa deepfake?

Il termine deepfake deriva da un omonimo utente di Reddit che nel 2017 condivideva su r/deepfakes centinaia di falsi video pornografici in cui i volti di personaggi famosi venivano “ricuciti” su attori del settore. L’utente Reddit non aveva fatto altro che riutilizzare a piacimento una famosa ricerca dell’Università di Washington, in cui, tramite la tecnica dell’apprendimento automatico (deep learning), si cercava di sfruttare un’IA per sovrapporre immagini e video esistenti di Barak Obama con video, audio o immagini originali. Un processo molto simile a quello che oggi NVIDIA utilizza per trasferire l’immagine e l’identità di attori reali all’interno di un videogame.

Quando un’IA diventa “di massa”

Pian piano la tecnologia alla base delle ricerche citate è diventata “di uso comune” nel web, anche grazie ad app molto conosciute come “Faceapp” o la più complessa “Deep Face Lab“.

L’estrema facilità di montaggio ha portato gli utenti di internet a sfogare tutta la loro creatività tramite challenge virali. I veri amanti dei meme ricorderanno di certo il periodo in cui il volto di Nicholas Cage veniva “incollato” su praticamente tutti i film in circolazione (se vi state chiedendo il motivo state già commettendo un errore, nel mondo dei meme le motivazioni sono sempre molto labili).

La tecnologia in questione però è stata utilizzata anche per motivi decisamente più interessanti: a maggio del 2019, un laboratorio Samsung con sede in Russia, ha utilizzato la tecnica del deep learning per dar vita a famosi quadri, come l’eterna Monnalisa, attraverso una banca dati di 7000 immagini, riuscendo addirittura ad insegnare all’algoritmo come riconoscere e distinguere i movimenti del volto umano.

Il risultato sembra strabiliante, pensate anche solo per un secondo a un museo in cui i quadri si “raccontano” da soli grazie al loro alter ego digitale.

Nello stesso anno, lo youtuber “derpfakes“, ha sfruttato la rete neurale per analizzare le sembianze di una ventunenne Carrie Fisher e riportarla in vita in tutto il suo splendore nel film del 2016 Rogue One, a suo dire “mettendoci lo stesso tempo che si utilizza per guardare una puntata dei Simpsons”. In questo modo lo youtuber cercava di dimostrare come, grazie al deep learning, un PC Desktop da 800$ fosse in qualche modo in grado di eguagliare milioni di dollari hollywoodiani spesi in CGI.

Quando i deepfakes si intromettono nel dibattito pubblico

Lo stesso youtuber aveva precedentemente pubblicato un video in cui sfruttava un’interpretazione di Donald Trump, eseguita da Jimmi Fallon della NBC, per creare un video deepfake del Tycoon. Il video in questione utilizzava le stesse parole del discorso di Fallon, ma questa volta sfoggiava i veri connotati di Donald Trump. Grazie a questo e a molti altri video simili, gli ambienti politici americani e non, iniziarono a sospettare di questa tecnologia, intuendo quanto essa potesse essere potenzialmente dannosa per la libertà d’informazione e di scelta, in particolare se utilizzata per prendere di mira i protagonisti della res publica attraverso video con contenuti molto meno “leggeri” e magari anche capaci di influenzare in qualche modo l’opinione pubblica.

Torniamo per un attimo alla situazione descritta inizialmente: vere o meno, le accuse di falso lanciate dalle opposizioni nei confronti del video di auguri di Ali Bongo, portarono il Paese in una situazione di instabilità ancora più profonda, fino a quando, una settimana dopo l’uscita del video, l’esercito tentò addirittura di prendere il potere con un golpe (rivelatosi poi fallimentare). Questo evento ci deve naturalmente portare a ragionare sulle possibile conseguenze della diffusione di simili video in una Nazione in via di sviluppo e quindi con minori “sistemi di controllo” che aiutino a limitare l’impatto di questi falsi. Se infatti un falso video scandalistico riesce a creare scompiglio in uno Stato con un sistema di informazione pieno di pesi e contrappesi, l’impatto che i deepfakes potrebbero avere su questi Paesi privi di controlli e con una scarsa libertà d’informazione può essere davvero devastante.

Alla fine del discorso non è mai stato realmente dimostrato se il video di auguri fosse un falso oppure no (in quanto ci sono diversi e autorevoli pareri contrastanti), ma una cosa è certa:

una volta che una narrazione politica viene spostata, è quasi impossibile riportarla alla sua traiettoria originale

- Eileen Donahoe

È proprio da questa frase che possiamo intuire tutti i potenziali problemi riguardanti la tecnologia deepfakes, problemi che, in ogni caso, non riguardano esclusivamente i Paesi in via di sviluppo.

Se qualcuno inizia a credere a un video falso quel qualcuno è stato già in qualche modo influenzato nel campo delle sue scelte. Del resto conosciamo storie di persone che credono in scie chimiche, rettiliani, pianeti con forme discutibili e vari complotti decisamente poco credibili, pensate a quello che potrebbe fare a delle persone così facilmente influenzabili un video ultra-realistico in cui uno statista pronuncia frasi diversamente impronunziabili. Allo stesso modo la tecnologia del deep learning potrebbe influenzare anche persone più scrupolose, sviluppando in loro un senso di diffidenza tale che, una volta posti davanti ad un vero scandalo, potrebbero rischiare di bollarlo semplicemente come un fake frutto della mente di qualche “troll” di internet.

Conclusioni. Deepfake: esiste una soluzione?

Come già detto e come del resto è stato ampiamente dimostrato dal fenomeno delle “fake news“, neanche i Paesi più industrializzati sono immuni dal “pericolo” deepfake. Basti pensare al maggio del 2019, quando si diffuse un deepfake di una Nancy Pelosi ubriaca durante un discorso pubblico. Il video divenne immediatamente virale, fu condiviso dallo stesso Donald Trump e solo successivamente riconosciuto come falso. Facebook in quell’occasione si rifiutò di rimuovere il video dai social, dichiarando di averne “ridotto la distribuzione una volta appurata non veridicità”. A quel punto, tuttavia, il video aveva già avuto un’ampia diffusione e molti erano arrivati alle loro personalissime conclusioni. Il sistema di pesi e contrappesi tipico dei Paesi moderni aveva miseramente fallito e ancora una volta gli USA avevano dimostrato di essere dipendenti dalle decisioni del colosso di Mark Zuckerberg.

Lo stesso Senato statunitense, tramite alcuni esponenti del partito repubblicano, tentò inutilmente di mettere in guardia il Governo sulla possibilità che i deepfakes rischiavano di compromettere addirittura le presidenziali, immaginando uno scenario in cui uno di quei video diventava virale il giorno prima delle elezioni, per poi essere “smascherato” solo successivamente.

La maggior parte delle possibili soluzioni ai rischi citati derivano da Università o centri di ricerca privati come la Faculty di Londra. Il centro in questione è infatti attualmente impegnato, non solo nella creazione di un’immensa biblioteca multimediale con lo scopo di permettere a dei software automatici la distinzione tra video reali e falsi, ma sta anche indagando sui rischi a lungo termine del deep learning, attraverso la creazione di un modello d’audio deepfake basato ancora una volta sulla voce di Donald Trump. Nell’audio la voce viene riprodotta in maniera assolutamente identica a quella dell’ex presidente USA, permettendo così al software in costruzione di acquisire maggiori informazioni sulle tracce audio create ad hoc.

Microsoft ha inoltre annunciato il lancio di un tool in grado di generare una percentuale di autenticità per qualunque video inserito, in modo da aiutare a prevenire il pericolo deepfake nell’ambito delle presidenziali appena concluse. Il tool tuttavia è sembrato da subito lacunoso e non affidabile al 100%, di conseguenza il rischio sembra ancora molto forte e probabilmente potrà essere risolto solo da un sistema di etichettatura social. Un sistema simile a quello che l’UE utilizza per i prodotti DOP, ma collocato nell’universo dei contenuti multimediali presenti sui Social Network. Un meccanismo che comunque presenta non pochi punti di domanda riguardanti efficacia e operabilità…

La dura verità è che fino a quando questi sistemi di difesa non diventeranno effettivi la credibilità dell’informazione web resterà potenzialmente in balia di queste minacce a lungo termine, mettendo a rischio la libertà d’informazione e conseguentemente, la libertà di molti di effettuare scelte politiche informate e consapevoli.

Per adesso la mia speranza è che in Italia, all’interno del delicato castello di carte del dibattito politico, i deepfakers si limitino esclusivamente a video amatoriali e satirici come questo, piuttosto che a contenuti più elaborati e con tematiche decisamente più insidiose.

0 Comments